ollama 설치하기

ollama는 llama와 같은 오픈 소스 대규모 언어 모델을 로컬에서 실행할 수 있게 도와주는 프로그램이다.

Ollama

Get up and running with large language models.

ollama.com

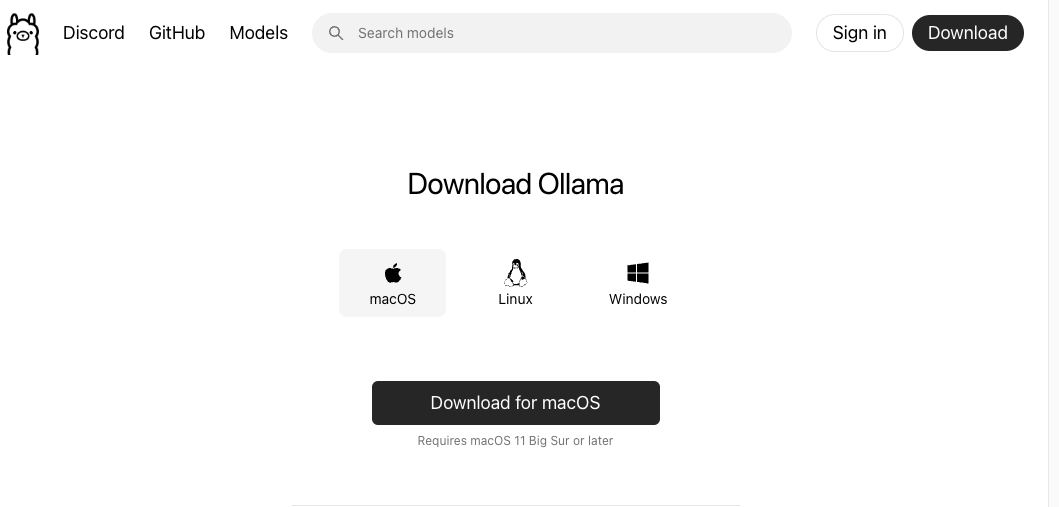

1. Ollama 홈페이지에 들어가면 다음과 같이 다운로드할 수 있는 화면이 뜬다. > 운영체제에 맞게 다운로드하면 된다.

설치하면 이렇게 Ollama 응용 프로그램이 생성되어있다.

2. Ollama를 더블클릭하면 다음과 같이 권한 체크하는 모달이 뜬다. 다 체크해서 넘어가자.

완료하면 이렇게 "Welcome to Ollama"라는 문구와 함께 애플리케이션이 정상적으로 동작한다.

이제 ollama를 쓸 준비가 다 되었다!

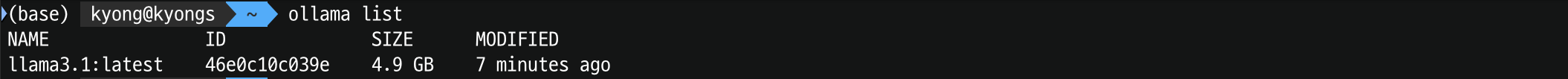

3. `ollama pull <name-of-model>` 명령어를 사용하여 사용 가능한 LLM 모델을 가져오면 된다.

`ollama list` 명령어를 통해 가져온 모든 모델을 확인할 수 있다.

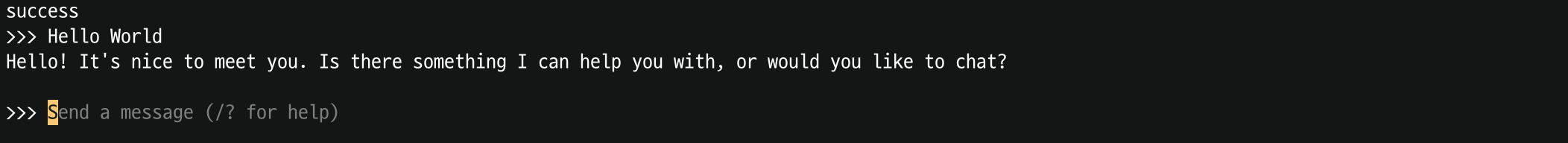

4. 잘되는지 한번 확인해보자. 사용하고 싶은 모델을 ollama 명령어와 함께 입력하면 된다.

ollama에서 지원하는 모델은 아래 페이지에 상세히 기재되어있다.

Ollama

Get up and running with large language models.

ollama.com

나는 llama 3.1이 필요해서, 터미널 창을 켜고 다음과 같이 명령어를 입력하였다.

`ollama run llama3.1`

시간이 좀 걸린다. 한 5분정도? 그리고 4.9GB나 되는걸 보니 로컬 용량도 미리 확보해놓는게 좋을듯하다.

❇︎ 모델을 삭제하려면

ollama rm <model명>

Langchain과 연결하기

1. langchain 설치

로컬 파이썬 환경에서 pip install 명령어를 통해 langchain을 install한다.

pip install langchain

2. langchain을 통해 Ollama 연결

from langchain_community.llms import Ollama

llm = Ollama(

model="llama3.1:70b",

format="json",

temperature=0,

)

prompt = "Hello World"

response = llm.invoke(prompt)

print(response.content)

사용 후기

로컬에서 실행하게 해준다는 설명을 들으면서 눈치챘어야 했는데,,,

ollama는 llama3.1과같은 모델을 로컬에 직접 다운로드받아 사용하는거라 문제가 있다.

예를 들어서 llama 3.1:405B는 200GB가 넘기 때문에 로컬에 다운받기에는 무리가 있다.

또한 오픈소스 언어모델 실행 시에 현재 설치한 로컬 장비 성능에 performance가 좌우된다.

'개발일지' 카테고리의 다른 글

| 파이썬 설치 (mac🍏) (0) | 2025.01.28 |

|---|---|

| device mount하는 방법 (Linux) (0) | 2025.01.22 |

| Latex 한글 쓰기 (0) | 2024.10.17 |

| 티스토리 수식 넣기 (0) | 2024.10.12 |

| AWS OpenSearch 도메인 생성 방법 (0) | 2024.08.27 |

전공 공부 기록 📘

포스팅이 좋았다면 "좋아요❤️" 또는 "구독👍🏻" 해주세요!